Deepfake: jak sztuczna inteligencja może nas oszukiwać?

Jako ludzie mamy niezwykłą umiejętność dostosowywania się do zmiennego środowiska. W przeciągu kilku ostatnich dekad największą zmianę naszego sposobu życia zakreślał rozwój technologiczny w dziedzinie informatyki. Wraz z nim, potrafiliśmy na przestrzeni kilkunastu lat dostosować się do nowych możliwości i wykorzystać je w swoim codziennym życiu. Komputery, telefony komórkowe, internet – za ich sprawą zupełnie zmieniliśmy sposób pracowania, odpoczywania oraz porozumiewania się z innymi ludźmi. Możemy zacząć dzień pracy z dowolnego miejsca na Ziemi, słuchając w międzyczasie naszej ulubionej muzyki , aby po południu zrelaksować się przy dowolnym filmie lub porozmawiać z przyjaciółmi z drugiego końca świata. Nasza adaptacja jest tak skuteczna, że dziś nie wyobrażamy sobie życia bez technologii, których istnienie jeszcze niedawno było nie do pomyślenia.

Dziś stoimy na przełomie kolejnego przewrotu środowiskowego, za sprawą sztucznej inteligencji (SI). Choć jej intensywny rozwój trwa od zaledwie kilku lat, już teraz daje ona niespotykane wcześniej możliwości i będzie wyznaczać trendy w najbliższych dekadach. Oznacza to, że będziemy musieli dostosować się do nowej rzeczywistości - nauczyć się wykorzystywać SI, ale również uświadamiać sobie, jakie zagrożenia niosą niektóre jej zastosowania.

Wyjątkowo niebezpieczną technologią jest "deepfake", za sprawą której zaciera się granica między prawdą a fałszem. Informacja jest równie wiarygodna, co dezinformacja, a do ich weryfikacji nie wystarczą nasze oczy i uszy. W niniejszym artykule chcielibyśmy przybliżyć tę technologię i jej możliwości, a także omówić jej potencjalne zagrożenia. Opiszemy też sposoby, jak można rozpoznawać sfałszowane materiały.

Kilka słów o inteligencji

Inteligencja to zdolność do przetwarzania informacji, wykorzystywania wiedzy oraz rozwiązywania problemów. Ludzka inteligencja przewyższa intelekt innych zwierząt, ponieważ pozwala nam abstrakcyjnie myśleć, logicznie rozumować, szybciej się uczyć i bardziej elastycznie podejmować decyzje. Dzięki postępującemu rozwojowi technologii część cech i umiejętności, które przypisywaliśmy wyłącznie ludziom, możemy dziś dzielić z maszynami. Poprzez zaprojektowanie specjalnych programów zdolnych do korygowania swojego działania w zależności od jego efektu, możemy stworzyć maszyny zdolne do wykonywania specyficznych, skomplikowanych i abstrakcyjnych zadań: rozpoznawania obiektów na zdjęciach, zapisywania wypowiadanych przez nas słów lub malowania obrazów na podstawie opisu tekstowego.

Inteligencja to zdolność do przetwarzania informacji, wykorzystywania wiedzy oraz rozwiązywania problemów. Ludzka inteligencja przewyższa intelekt innych zwierząt, ponieważ pozwala nam abstrakcyjnie myśleć, logicznie rozumować, szybciej się uczyć i bardziej elastycznie podejmować decyzje. Dzięki postępującemu rozwojowi technologii część cech i umiejętności, które przypisywaliśmy wyłącznie ludziom, możemy dziś dzielić z maszynami. Poprzez zaprojektowanie specjalnych programów zdolnych do korygowania swojego działania w zależności od jego efektu, możemy stworzyć maszyny zdolne do wykonywania specyficznych, skomplikowanych i abstrakcyjnych zadań: rozpoznawania obiektów na zdjęciach, zapisywania wypowiadanych przez nas słów lub malowania obrazów na podstawie opisu tekstowego.Czym jest deepfake?

W podobny sposób możemy stworzyć maszynę specjalizującą się w rozpoznawaniu twarzy i innych szczegółów mimicznych. Taka maszyna będzie wiedziała, gdzie są oczy, usta oraz jak mogą się poruszać podczas mówienia lub okazywania emocji. Wiedzę tę może następnie przenieść na inną twarz - na przykład ze zdjęcia i zasymulować podobne ruchy. W rezultacie otrzymuje się tak zwanego deepfake'a, czyli manipulację obrazu twarzy, często w celu całkowitej podmiany tożsamości.

Rodzaje deepfake'ów

Pierwotnie terminem deepfake nazywano jedynie zamianę twarzy na materiałach wideo. Jednak z czasem rozszerzono znaczenie tego słowa o inne manipulacje mające na celu zmianę cech twarzy, całkowitą podmianę tożsamości, a także modyfikacje głosu. Może mieć to ciekawe zastosowania, a w niektórych branżach doprowadzić do prawdziwej rewolucji.

Pierwotnie terminem deepfake nazywano jedynie zamianę twarzy na materiałach wideo. Jednak z czasem rozszerzono znaczenie tego słowa o inne manipulacje mające na celu zmianę cech twarzy, całkowitą podmianę tożsamości, a także modyfikacje głosu. Może mieć to ciekawe zastosowania, a w niektórych branżach doprowadzić do prawdziwej rewolucji.Podmiana tożsamości (identity swap)

Metoda, która pozwala na zamianę twarzy na zdjęciach lub wideo, a jednocześnie pozostawia resztę ciała bez zmian. Technika ta może być niezwykle przydatna, szczególnie w branży filmowej. Jest to idealny sposób na dostosowanie twarzy kaskadera do aktora lub dogranie scen z pomocą dublera. Dzięki takiemu podejściu, tworzenie filmów staje się łatwiejsze, a proces produkcji przyspiesza, co z kolei umożliwia szybsze i tańsze dostarczenie rozrywki na ekrany.

Odtwarzanie twarzy (face reenactment)

Technika odtwarzania twarzy - znana także jako rekonstrukcja twarzy - umożliwia precyzyjne odtworzenie mimiki oraz ruchów oczu i ust osoby uwiecznionej na nagraniu. Dzięki temu rozwiązaniu możliwe jest poruszanie twarzą ze zdjęcia. Technika ta może być użyta przy dubbingu filmów animowanych lub korekty ujęć. Z tego względu cieszy się ona rosnącą popularnością w branży filmowej i reklamowej, ponieważ umożliwiaj twórcom osiągnięcie niezwykle realistycznych efektów wizualnych.

[Źródło : https://www.cined.com/face2face-real-time-face-capture-and-reenactment-of-videos/]

[Źródło : https://www.cined.com/face2face-real-time-face-capture-and-reenactment-of-videos/]

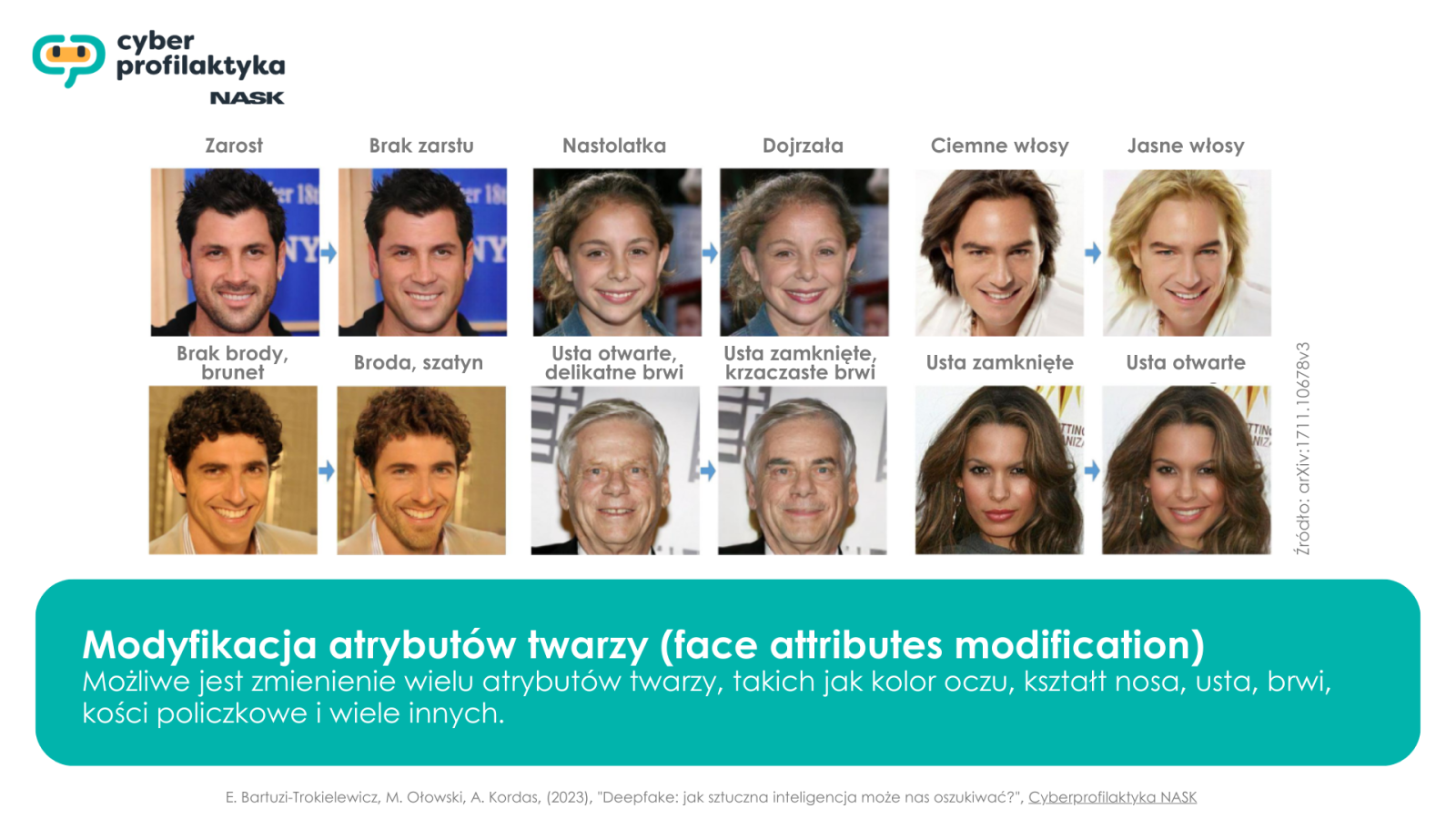

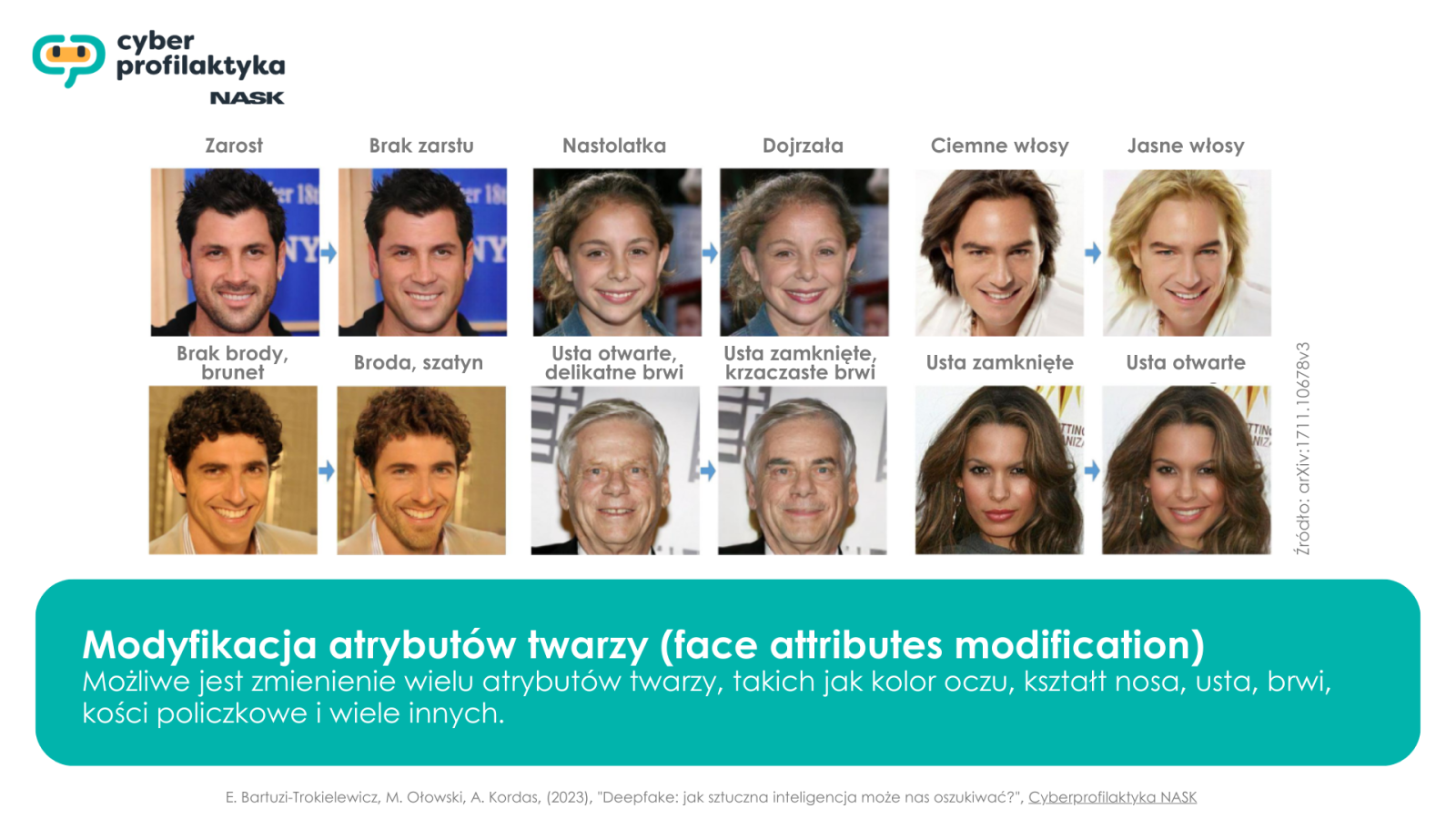

Modyfikacja atrybutów twarzy (face attributes modification)

To proces modyfikacji wyglądu i cech twarzy na nagraniach wideo. Umożliwia zmienienie wielu atrybutów twarzy, takich jak: kolor oczu, kształt nosa, usta, brwi, kości policzkowe i wiele innych. W efekcie osoba na nagraniu może zostać subiektywnie upiększona lub zyskać zupełnie nowe cechy twarzy. Takie rozwiązanie może być wykorzystane w filmie, reklamie lub innych produkcjach, gdzie zachodzi potrzeba delikatnej korekty wyglądu występującej osoby.

Przykładem zastosowania tej techniki są popularne filtry w różnych aplikacjach i portalach społecznościowych, które umożliwiają nakładanie na twarz użytkownika różnych masek oraz efektów specjalnych. Ta technologia stale się rozwija, tworząc coraz więcej możliwości manipulowania wizerunkiem.

Przykładem zastosowania tej techniki są popularne filtry w różnych aplikacjach i portalach społecznościowych, które umożliwiają nakładanie na twarz użytkownika różnych masek oraz efektów specjalnych. Ta technologia stale się rozwija, tworząc coraz więcej możliwości manipulowania wizerunkiem.

Łączenie twarzy (face blending)

Face blending to technika polegająca na połączeniu dwóch lub więcej twarzy w celu stworzenia twarzy osoby przypominającej te wykorzystane podczas omawianego procesu. W porównaniu do metody podmiany twarzy, face blending jest łatwiejszy do wykonania, ponieważ nie wymaga tak precyzyjnego dopasowania pozycji, oświetlenia i kształtu twarzy. Ta technika wykorzystywana jest np. w aplikacjach próbujących w ten sposób przewidzieć, jak wyglądałby potomek dwóch osób.

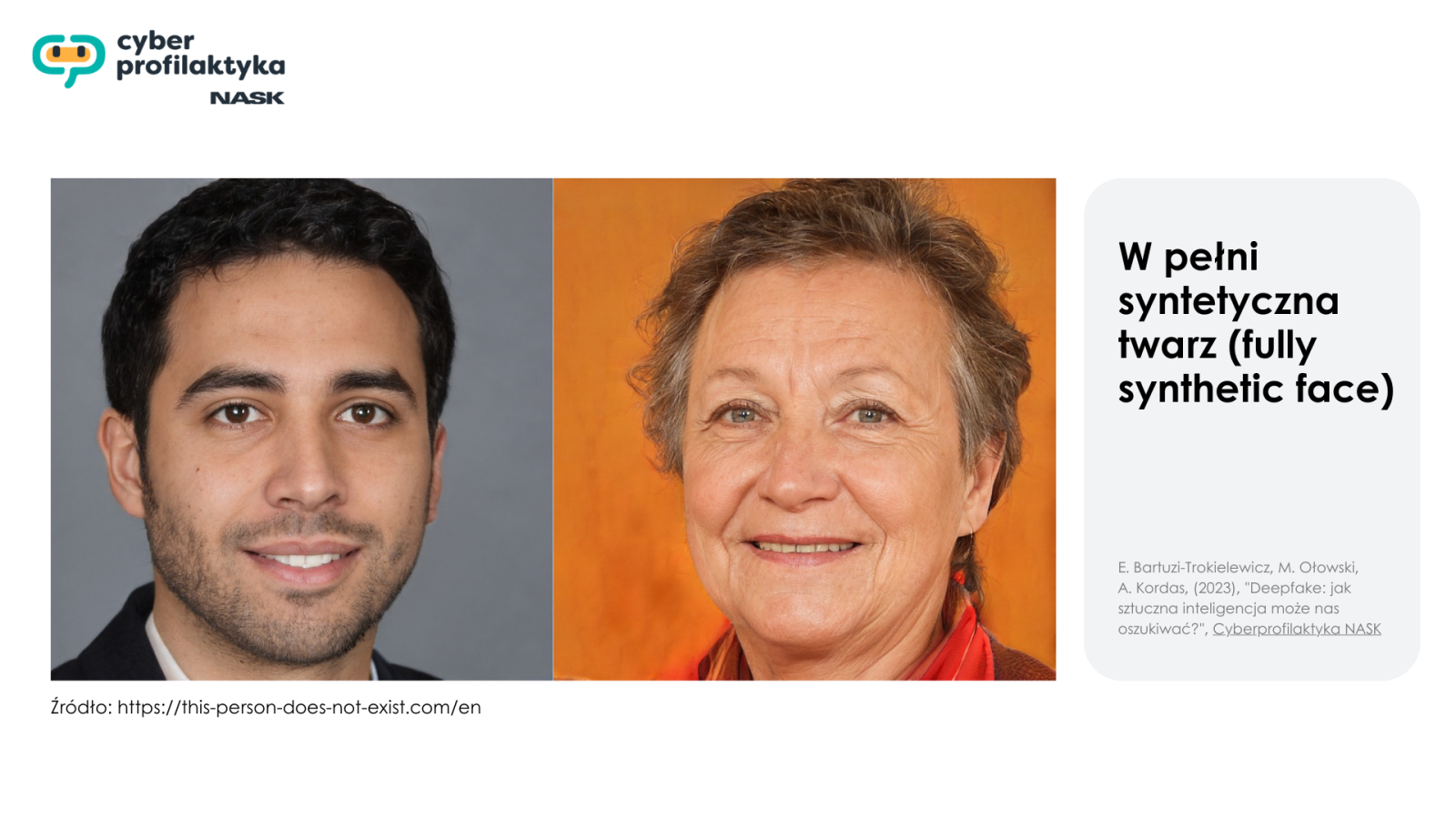

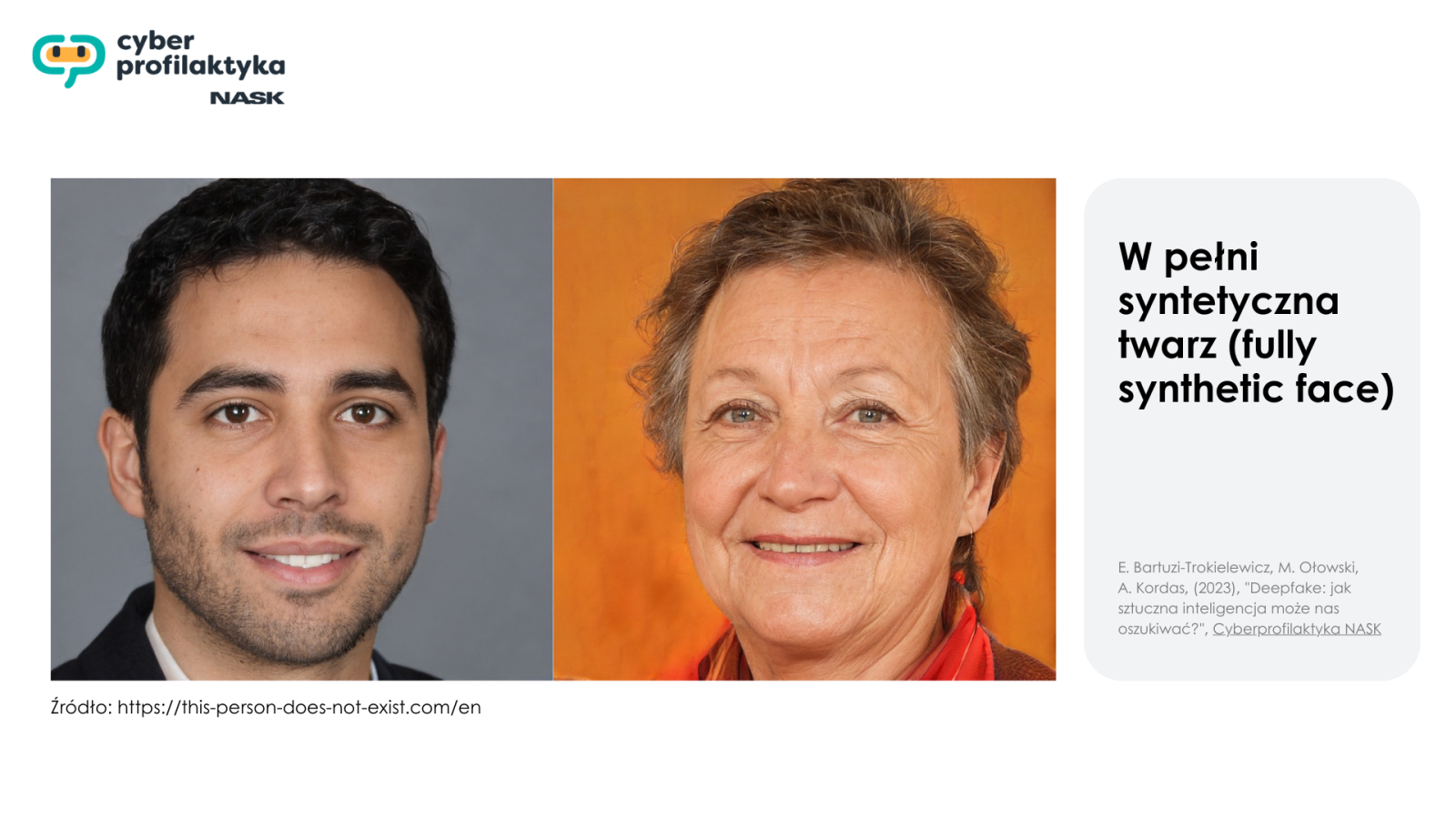

W pełni syntetyczna twarz (fully synthetic face)

Wynikiem tego algorytmu jest twarz osoby, która tak naprawdę wcale nie istnieje. Algorytm wie, jak wygląda tekstura skóry, gdzie powinny znajdować się oczy, nos i inne cechy twarzy, dzięki czemu generowana jest wizualizacja, która wygląda na realistyczną, ale nie jest powiązana z żadną rzeczywistą osobą.

Za interaktywny przykład może posłużyć strona internetowa, która pozwala na stworzenie ludzkiej twarzy. Po każdym odświeżeniu, pojawi się nowe syntetyczne zdjęcie nieistniejącej osoby.

Za interaktywny przykład może posłużyć strona internetowa, która pozwala na stworzenie ludzkiej twarzy. Po każdym odświeżeniu, pojawi się nowe syntetyczne zdjęcie nieistniejącej osoby.

Jak to działa?

Deepfake'i są tworzone za pomocą sieci generatywnych – GAN (ang. Generative Adversarial Networks). To właśnie ta technika umożliwia tworzenie realistycznych i praktycznie niemożliwych do wykrycia efektów wizualnych, które na pierwszy rzut oka wydają się autentyczne.

Sieci GAN to specjalny rodzaj modeli komputerowych, które umożliwiają tworzenie materiałów, przypominających dane, na których były trenowane. Składają się z dwóch części: generatora i dyskryminatora. Generator próbuje tworzyć nowe dane o podobnych cechach do danych treningowych, takich jak zawartość, kształty, położenie i kolor. Z kolei dyskryminator ma za zadanie odróżniać oryginalne dane od tych wygenerowanych przez generator. Można sobie to wyobrazić jako walkę artysty-fałszerza i detektywa. Artysta-fałszerz (generator) stara się malować obrazy, które wyglądają jak prawdziwe, natomiast detektyw (dyskryminator) próbuje odróżnić prawdziwe obrazy od tych podrobionych. Nauczenie sieci GAN polega na ciągłym treningu tych dwóch części. Im dłużej trwa trening, tym lepszy staje się artysta w malowaniu realistycznych obrazów, a detektyw w rozpoznawaniu, które są prawdziwe, a które zostały wygenerowane. Celem tego algorytmu jest osiągnięcie tak dobrych obrazów, by nie tylko detektyw został oszukany, ale również człowiek.

Sieci GAN to specjalny rodzaj modeli komputerowych, które umożliwiają tworzenie materiałów, przypominających dane, na których były trenowane. Składają się z dwóch części: generatora i dyskryminatora. Generator próbuje tworzyć nowe dane o podobnych cechach do danych treningowych, takich jak zawartość, kształty, położenie i kolor. Z kolei dyskryminator ma za zadanie odróżniać oryginalne dane od tych wygenerowanych przez generator. Można sobie to wyobrazić jako walkę artysty-fałszerza i detektywa. Artysta-fałszerz (generator) stara się malować obrazy, które wyglądają jak prawdziwe, natomiast detektyw (dyskryminator) próbuje odróżnić prawdziwe obrazy od tych podrobionych. Nauczenie sieci GAN polega na ciągłym treningu tych dwóch części. Im dłużej trwa trening, tym lepszy staje się artysta w malowaniu realistycznych obrazów, a detektyw w rozpoznawaniu, które są prawdziwe, a które zostały wygenerowane. Celem tego algorytmu jest osiągnięcie tak dobrych obrazów, by nie tylko detektyw został oszukany, ale również człowiek.

Sieci GAN to specjalny rodzaj modeli komputerowych, które umożliwiają tworzenie materiałów, przypominających dane, na których były trenowane. Składają się z dwóch części: generatora i dyskryminatora. Generator próbuje tworzyć nowe dane o podobnych cechach do danych treningowych, takich jak zawartość, kształty, położenie i kolor. Z kolei dyskryminator ma za zadanie odróżniać oryginalne dane od tych wygenerowanych przez generator. Można sobie to wyobrazić jako walkę artysty-fałszerza i detektywa. Artysta-fałszerz (generator) stara się malować obrazy, które wyglądają jak prawdziwe, natomiast detektyw (dyskryminator) próbuje odróżnić prawdziwe obrazy od tych podrobionych. Nauczenie sieci GAN polega na ciągłym treningu tych dwóch części. Im dłużej trwa trening, tym lepszy staje się artysta w malowaniu realistycznych obrazów, a detektyw w rozpoznawaniu, które są prawdziwe, a które zostały wygenerowane. Celem tego algorytmu jest osiągnięcie tak dobrych obrazów, by nie tylko detektyw został oszukany, ale również człowiek.

Sieci GAN to specjalny rodzaj modeli komputerowych, które umożliwiają tworzenie materiałów, przypominających dane, na których były trenowane. Składają się z dwóch części: generatora i dyskryminatora. Generator próbuje tworzyć nowe dane o podobnych cechach do danych treningowych, takich jak zawartość, kształty, położenie i kolor. Z kolei dyskryminator ma za zadanie odróżniać oryginalne dane od tych wygenerowanych przez generator. Można sobie to wyobrazić jako walkę artysty-fałszerza i detektywa. Artysta-fałszerz (generator) stara się malować obrazy, które wyglądają jak prawdziwe, natomiast detektyw (dyskryminator) próbuje odróżnić prawdziwe obrazy od tych podrobionych. Nauczenie sieci GAN polega na ciągłym treningu tych dwóch części. Im dłużej trwa trening, tym lepszy staje się artysta w malowaniu realistycznych obrazów, a detektyw w rozpoznawaniu, które są prawdziwe, a które zostały wygenerowane. Celem tego algorytmu jest osiągnięcie tak dobrych obrazów, by nie tylko detektyw został oszukany, ale również człowiek.Dezinformacja a deepfake

Era internetu to era informacji – za pośrednictwem tego medium mamy dostęp do niezliczonych źródeł wiedzy i wiadomości, a dzięki blogom czy portalom społecznościowym, każdy może stać się aktywnym twórcą oraz publikować własne treści. Rodzi to jednak ryzyko natrafienia na nieprawdziwe informacje, udostępniane z powodu braku wiedzy autora lub z premedytacją wprowadzające odbiorców w błąd.

Era internetu to era informacji – za pośrednictwem tego medium mamy dostęp do niezliczonych źródeł wiedzy i wiadomości, a dzięki blogom czy portalom społecznościowym, każdy może stać się aktywnym twórcą oraz publikować własne treści. Rodzi to jednak ryzyko natrafienia na nieprawdziwe informacje, udostępniane z powodu braku wiedzy autora lub z premedytacją wprowadzające odbiorców w błąd.Umiejętność krytycznej selekcji informacji jest kluczowa w czerpaniu wartościowej wiedzy z infosfery. Niestety zjawisko deepfake'ów dodatkowo wpłynęło na poziom trudności weryfikacji wiarygodnych treści. Postęp technologii może spowodować, że w przyszłości niełatwo będzie się rozróżniać deepfake'i od autentycznego materiału. Choć wydaje się to odległą perspektywą, niektóre z przykładów pokazują, że już teraz potrafią one być nie do odróżnienia od prawdziwej twarzy. Można założyć, że w najbliższych latach takie rozwiązania będą stawać się coraz lepsze, ale też łatwiej dostępne, a przez to ich wykorzystanie będzie w pełni zależne od intencji twórców.

Technologia deepfake, gdy jest w rękach osób o złych intencjach, może być wykorzystana do szerzenia nieprawdziwych informacji, manipulowania opinią publiczną, a także tworzenia lub nasilania niepokojów społecznych. Nawet te słabej jakości są niebezpiecznym narzędziem, ponieważ mogą wyrządzić szkody zanim informacja o jego spreparowaniu dotrze do szerszego grona odbiorców. Przykładem mogą być deepfake’i, które mogłyby znacząco wpłynąć na wyniki wyborów, dyskredytując czołowego polityka niedługo przed dniem głosowania.

Z drugiej strony istnienie deepfake’ów może też prowadzić do paradoksu, w którym wszelkie audiowizualne dowody, działające na czyjąś niekorzyść mogą zostać odrzucone jako spreparowane. Osoby słusznie oskarżane mogą w ten sposób czerpać korzyść z przekonania szerszego grona do swojego kłamstwa. Taki proceder nazywa się "dywidendą kłamcy".

Wyłudzenia za pomocą deepfake’ów

Wyobraźmy sobie, że dzwoni do nas ktoś podający się za prezydenta USA i z nienaganną polszczyzną przekonuje nas, że jesteśmy zaproszeni na wycieczkę do Nowego Yorku, a jedyne co musimy zrobić to opłacić przesyłkę pocztową pod wskazanym linkiem... Oczywiście brzmi to, co najmniej podejrzanie. Jest to hipotetyczny przykład telefonicznej próby wyłudzenia pieniędzy. Wyjątkowo naiwnej dodajmy, bo dzwoniący zupełnie nie brzmiał jak obecny prezydent, ani żaden z poprzednich.

Wyobraźmy sobie, że dzwoni do nas ktoś podający się za prezydenta USA i z nienaganną polszczyzną przekonuje nas, że jesteśmy zaproszeni na wycieczkę do Nowego Yorku, a jedyne co musimy zrobić to opłacić przesyłkę pocztową pod wskazanym linkiem... Oczywiście brzmi to, co najmniej podejrzanie. Jest to hipotetyczny przykład telefonicznej próby wyłudzenia pieniędzy. Wyjątkowo naiwnej dodajmy, bo dzwoniący zupełnie nie brzmiał jak obecny prezydent, ani żaden z poprzednich.A co gdyby brzmiał dokładnie tak jak on?

Za sprawą deepfake'ów można podmienić swój głos na głos dowolnej osoby, od której atakujący posiada dostatecznie długie nagranie. W przypadku osób publicznych, jak prezydent dużego państwa, ten warunek jest prosty do spełnienia. W takiej sytuacji kontekst rozmowy może być dalej absurdalny, ale nasza czujność zostanie na tyle stępiona przez znajomy głos, żebyśmy byli mniej podejrzliwi.

Za sprawą deepfake'ów można podmienić swój głos na głos dowolnej osoby, od której atakujący posiada dostatecznie długie nagranie. W przypadku osób publicznych, jak prezydent dużego państwa, ten warunek jest prosty do spełnienia. W takiej sytuacji kontekst rozmowy może być dalej absurdalny, ale nasza czujność zostanie na tyle stępiona przez znajomy głos, żebyśmy byli mniej podejrzliwi.Pójdźmy o krok dalej i przygotujmy inne scenariusze. Znany redaktor radiowy ogłaszający wygraną w konkursie; autorytet świata biznesu zachęcający do inwestycji w nową krypto walutę; szef firmy dzwoniący do swoich pracowników i zlecający zrealizowanie przelewu na wskazane konto. To już są zupełnie wiarygodne sytuacje, w których wiele osób mogłoby się znaleźć. Dodajmy do tego odpowiedni głos i nawet najbardziej ostrożny czytelnik nie rozpozna w tym niczego podejrzanego. A możemy pójść jeszcze dalej...

Twórcy najlepszych rozwiązań w dziedzinie sztucznej inteligencji wyspecjalizowanej w kopiowaniu głosu prześcigają się w długości próbki potrzebnej do jego skopiowania. Już teraz wystarczy zaledwie kilkadziesiąt sekund nagrania mowy, aby kopiowanie było możliwe. Za sprawą materiałów, które sami publikujemy na portalach społecznościowych, będzie można podrobić głos niemal dowolnej osoby. Ktoś mógłby na przykład wykorzystać nasze nagranie z wakacji, skopiować głos członka naszej rodziny i użyć go do oszustwa. Niedawne doniesienia medialne pokazują, że takie próby już są podejmowane w różnych celach. Coraz częściej zdarzają się sytuacje, że np. głos dziecka jest używany do tworzenia fałszywych nagrań związanych z porwaniem, wprowadzaniem rodziców w błąd w celach wyłudzenia okupu (więcej informacji). Spotykane są także przypadki szantażu seksualnego, którego celem są celebryci i politycy (więcej informacji). Przestępcy tworzą fałszywe materiały video, w których twarze znanych ludzi nakładane są na wizerunki innych osób uczestniczących w nieodpowiednich sytuacjach lub materiałach pornograficznych. Następnie przestępcy szantażują swoje ofiary, grożąc ujawnieniem takich deepfake'owych wideo, jeśli nie spełni się ich żądań. Choć prawdopodobieństwo tak precyzyjnie wymierzonego ataku jest małe, to samo istnienie takiej możliwości może być przerażające. Te przykłady pokazują, jak technologia deepfake może być wykorzystywane do manipulacji, szantażu oraz wprowadzania w błąd. W miarę rozwoju technologii deepfake, pojawia się pilna potrzeba opracowania skutecznych narzędzi i strategii obrony przed tego rodzaju oszustwami.

Twórcy najlepszych rozwiązań w dziedzinie sztucznej inteligencji wyspecjalizowanej w kopiowaniu głosu prześcigają się w długości próbki potrzebnej do jego skopiowania. Już teraz wystarczy zaledwie kilkadziesiąt sekund nagrania mowy, aby kopiowanie było możliwe. Za sprawą materiałów, które sami publikujemy na portalach społecznościowych, będzie można podrobić głos niemal dowolnej osoby. Ktoś mógłby na przykład wykorzystać nasze nagranie z wakacji, skopiować głos członka naszej rodziny i użyć go do oszustwa. Niedawne doniesienia medialne pokazują, że takie próby już są podejmowane w różnych celach. Coraz częściej zdarzają się sytuacje, że np. głos dziecka jest używany do tworzenia fałszywych nagrań związanych z porwaniem, wprowadzaniem rodziców w błąd w celach wyłudzenia okupu (więcej informacji). Spotykane są także przypadki szantażu seksualnego, którego celem są celebryci i politycy (więcej informacji). Przestępcy tworzą fałszywe materiały video, w których twarze znanych ludzi nakładane są na wizerunki innych osób uczestniczących w nieodpowiednich sytuacjach lub materiałach pornograficznych. Następnie przestępcy szantażują swoje ofiary, grożąc ujawnieniem takich deepfake'owych wideo, jeśli nie spełni się ich żądań. Choć prawdopodobieństwo tak precyzyjnie wymierzonego ataku jest małe, to samo istnienie takiej możliwości może być przerażające. Te przykłady pokazują, jak technologia deepfake może być wykorzystywane do manipulacji, szantażu oraz wprowadzania w błąd. W miarę rozwoju technologii deepfake, pojawia się pilna potrzeba opracowania skutecznych narzędzi i strategii obrony przed tego rodzaju oszustwami.Deepfake w celu preparowania pornografii

Skoro w łatwy sposób można zamienić twarze dowolnych osób, co stoi na przeszkodzie, by jedna z nich nie miała na sobie ubrań? Deepfake'owa pornografia jest niesławnym początkiem tej technologii – po raz pierwszy wykorzystano ją do zamiany twarzy aktorek filmów pornograficznych na twarze innych znanych osób. Moda na tego typu treści sprawia, że preparowanie pornografii stało się głównym wykorzystaniem deepfake'ów – według publikacji "The State of Deepfakes: Landscape, Threats, and Impact", aż 96% deepfake'ów powstaje właśnie w tym celu.

Skoro w łatwy sposób można zamienić twarze dowolnych osób, co stoi na przeszkodzie, by jedna z nich nie miała na sobie ubrań? Deepfake'owa pornografia jest niesławnym początkiem tej technologii – po raz pierwszy wykorzystano ją do zamiany twarzy aktorek filmów pornograficznych na twarze innych znanych osób. Moda na tego typu treści sprawia, że preparowanie pornografii stało się głównym wykorzystaniem deepfake'ów – według publikacji "The State of Deepfakes: Landscape, Threats, and Impact", aż 96% deepfake'ów powstaje właśnie w tym celu.Nie trudno jest się domyślić, jakie problemy niesie takie wykorzystanie technologii. Osoba przedstawiona na fałszywym materiale pornograficznym może czuć się skrzywdzona, upokorzona i bezbronna, a to może prowadzić do daleko idących szkód emocjonalnych oraz społecznych.

Gdy intencją twórcy deepfake'owej pornografii jest wyrządzenie bezpośredniej krzywdy wybranej osobie, konsekwencje są jeszcze poważniejsze. Fałszywy materiał może być użyty do szantażu lub wyłudzania pieniędzy. Może też być formą zemsty, narzędziem do nękania ofiary, próbą dyskredytacji w przestrzeni publicznej lub zniszczenia relacji osobistych.

Jak podają media, powyższe scenariusze już się dzieją:

- Gwiazda filmowa Scarlett Johansson wielokrotnie padła ofiarą deepfake, szczególnie w branży pornograficznej. Aktorka wypowiedziała "wojnę" takiemu zastosowania technologii i publicznie zwraca uwagę na zagrożenia z nią związane (czytaj więcej).

-

Policja zatrzymała mężczyznę, który tworzył nieetyczne materiały z wykorzystaniem deepfake. Ofiara postanowiła szerzyć informację o zagrożeniach związanych z tą technologią (czytaj więcej).

-

Policja zatrzymała grupę osób odpowiedzialnych za szantaż z wykorzystaniem deepfake jako narzędzia (czytaj więcej).

Sposoby radzenia sobie z deepfake'ami

Zdając sobie sprawę z potężnego zagrożenia, jakim są deepfake'i, powinniśmy podchodzić do wszelkich materiałów w internecie z większym krytycyzmem i czujnością. Kiedy natrafimy na kontrowersyjny film lub nagranie, warto zastanowić się czy nie jest on zmanipulowany, bądź wyciągnięty z kontekstu. Aby potwierdzić prawdziwość danej informacji, warto sprawdzić jej źródła lub poszukać potwierdzenia na innych stronach. Edukacja dzieci, młodzieży i osób starszych odgrywa kluczową rolę, ponieważ to one są szczególnie narażone na zagrożenia związane z deepfake'ami. Jest to głównie spowodowane ich niewystarczającą znajomością technologii oraz związanym z tym ryzykiem.

Zdając sobie sprawę z potężnego zagrożenia, jakim są deepfake'i, powinniśmy podchodzić do wszelkich materiałów w internecie z większym krytycyzmem i czujnością. Kiedy natrafimy na kontrowersyjny film lub nagranie, warto zastanowić się czy nie jest on zmanipulowany, bądź wyciągnięty z kontekstu. Aby potwierdzić prawdziwość danej informacji, warto sprawdzić jej źródła lub poszukać potwierdzenia na innych stronach. Edukacja dzieci, młodzieży i osób starszych odgrywa kluczową rolę, ponieważ to one są szczególnie narażone na zagrożenia związane z deepfake'ami. Jest to głównie spowodowane ich niewystarczającą znajomością technologii oraz związanym z tym ryzykiem. Nie możemy pozwolić sobie na bezkrytyczne zaufanie naszym zmysłom. Samo uświadomienie sobie zagrożeń związanych z deepfake'ami stanowi już dużą ochronę. Dlatego, kiedy widzimy nagranie znanej osoby, które wzbudza w nas podejrzenia, powinniśmy posłuchać swojej intuicji. Warto rozpoznawać emocje, jakie chce w nas wywołać dana treść. Strach, gniew czy presję czasu, która zmusza do szybkiego działania, mogą świadczyć o próbie zmanipulowania odbiorcą. Jeśli zobaczymy nagranie, na którym znana osoba wyraża kontrowersyjne poglądy, warto poszukać innych źródeł tej informacji. Może okazać się, że ktoś już zdemaskował oszustwo lub opublikował zweryfikowaną informację.

Nie możemy pozwolić sobie na bezkrytyczne zaufanie naszym zmysłom. Samo uświadomienie sobie zagrożeń związanych z deepfake'ami stanowi już dużą ochronę. Dlatego, kiedy widzimy nagranie znanej osoby, które wzbudza w nas podejrzenia, powinniśmy posłuchać swojej intuicji. Warto rozpoznawać emocje, jakie chce w nas wywołać dana treść. Strach, gniew czy presję czasu, która zmusza do szybkiego działania, mogą świadczyć o próbie zmanipulowania odbiorcą. Jeśli zobaczymy nagranie, na którym znana osoba wyraża kontrowersyjne poglądy, warto poszukać innych źródeł tej informacji. Może okazać się, że ktoś już zdemaskował oszustwo lub opublikował zweryfikowaną informację.Jednocześnie, aby skutecznie przeciwdziałać temu zajwisku, konieczne są zmiany legislacyjne. W wielu krajach prawnie regulowane są tylko niektóre formy manipulacji cyfrowej treści, a deepfake'i są w dalszym ciągu traktowane jako pewien rodzaj twórczości lub sztuki cyfrowej. Konieczne jest wprowadzenie nowych przepisów, które jednoznacznie określą odpowiedzialność za tworzenie i udostępnianie deepfake'ów, szczególnie jeśli naruszają one prywatność lub wizerunek innych osób. Sankcjami powinny być też obarczone osoby dopuszczające się takich działań.

Deepfake w świetle prawa

W polskim prawodawstwie nie ma przepisów bezpośrednio odnoszących się do technologii deepfake, a wprowadzenie ich jest otwartym wyzwaniem nie tylko dla Polski, ale wszystkich krajów na świecie. Mimo to, już dziś istnieją pewne przepisy, które przy odpowiedniej interpretacji mogą chronić przed tym zjawiskiem.

Naruszenie praw osobowych poprzez spreparowanie zdjęcia, filmu lub nagrania głosu za pomocą technologii deepfake może być traktowane jako naruszenie dóbr osobistych chronionych przez Kodeks Cywilny oraz inne przepisy prawa.

Naruszenie praw osobowych poprzez spreparowanie zdjęcia, filmu lub nagrania głosu za pomocą technologii deepfake może być traktowane jako naruszenie dóbr osobistych chronionych przez Kodeks Cywilny oraz inne przepisy prawa.

Osoba, która bez wyraźnej zgody została przedstawiona na fałszywym materiale może dochodzić swoich praw do ochrony wizerunku, prywatności i intymności życia prywatnego. W szczególności może domagać się usunięcia takiego materiału z internetu, zobowiązania do nieudostępniania go dalej oraz uzyskania odszkodowania za szkodę, jaką poniosła wskutek naruszenia swoich praw.

Warto zaznaczyć, że deepfake może naruszać nie tylko prawa osobiste, ale również może być używany w celu popełnienia przestępstw, takich jak oszustwa, wyłudzenia, szantaże i inne. W takich przypadkach, odpowiednie organy państwowe mogą prowadzić śledztwa i wszczynać postępowania karno-sądowe, aby ukarać sprawców.

Warto zaznaczyć, że deepfake może naruszać nie tylko prawa osobiste, ale również może być używany w celu popełnienia przestępstw, takich jak oszustwa, wyłudzenia, szantaże i inne. W takich przypadkach, odpowiednie organy państwowe mogą prowadzić śledztwa i wszczynać postępowania karno-sądowe, aby ukarać sprawców.

Powyższe konsekwencje prawne są możliwe jedynie w przypadku określonej interpretacji przepisów prawa. Zmiany ustawodawcze są otwartym problemem, a jego rozwiązaniem może być procedowane obecnie prawo europejskie, które po uchwaleniu, będzie wdrożone w państwach członkowskich Unii Europejskiej.

Naruszenie praw osobowych poprzez spreparowanie zdjęcia, filmu lub nagrania głosu za pomocą technologii deepfake może być traktowane jako naruszenie dóbr osobistych chronionych przez Kodeks Cywilny oraz inne przepisy prawa.

Naruszenie praw osobowych poprzez spreparowanie zdjęcia, filmu lub nagrania głosu za pomocą technologii deepfake może być traktowane jako naruszenie dóbr osobistych chronionych przez Kodeks Cywilny oraz inne przepisy prawa.Osoba, która bez wyraźnej zgody została przedstawiona na fałszywym materiale może dochodzić swoich praw do ochrony wizerunku, prywatności i intymności życia prywatnego. W szczególności może domagać się usunięcia takiego materiału z internetu, zobowiązania do nieudostępniania go dalej oraz uzyskania odszkodowania za szkodę, jaką poniosła wskutek naruszenia swoich praw.

Warto zaznaczyć, że deepfake może naruszać nie tylko prawa osobiste, ale również może być używany w celu popełnienia przestępstw, takich jak oszustwa, wyłudzenia, szantaże i inne. W takich przypadkach, odpowiednie organy państwowe mogą prowadzić śledztwa i wszczynać postępowania karno-sądowe, aby ukarać sprawców.

Warto zaznaczyć, że deepfake może naruszać nie tylko prawa osobiste, ale również może być używany w celu popełnienia przestępstw, takich jak oszustwa, wyłudzenia, szantaże i inne. W takich przypadkach, odpowiednie organy państwowe mogą prowadzić śledztwa i wszczynać postępowania karno-sądowe, aby ukarać sprawców.Powyższe konsekwencje prawne są możliwe jedynie w przypadku określonej interpretacji przepisów prawa. Zmiany ustawodawcze są otwartym problemem, a jego rozwiązaniem może być procedowane obecnie prawo europejskie, które po uchwaleniu, będzie wdrożone w państwach członkowskich Unii Europejskiej.

Prawo europejskie

AI Act (ang. "Artificial Intelligence Act") to propozycja prawa europejskiego dotycząca sztucznej inteligencji. Celem tej inicjatywy jest zapewnienie ochrony praw człowieka i podstawowych wolności, a także zapobieganie dyskryminacji, zwiększenie przejrzystości i zapewnienie bezpieczeństwa użytkowników. AI Act traktuje technologię deepfake jako jeden z przykładów systemów sztucznej inteligencji wysokiego ryzyka. W związku z tym, stosowanie jej podlega szczególnym wymaganiom i ograniczeniom. Twórcy deepfake'ów mają obowiązek wyraźnie oznaczyć, że dana treść jest generowana przez system sztucznej inteligencji i nie jest prawdziwym zapisem rzeczywistych zdarzeń. AI Act wprowadza również wymóg, aby przed publikacją, tacy twórcy przeprowadzali ocenę ryzyka, która pozwoli na zidentyfikowanie potencjalnego szkodliwego wpływu materiały na osoby, grupy społeczne i/lub na demokratyczne procesy. W przypadku, gdy istnieje ryzyko szkodliwego wpływu deepfake'u, jego publikacja może zostać zakazana lub poddana ścisłym ograniczeniom.

AI Act (ang. "Artificial Intelligence Act") to propozycja prawa europejskiego dotycząca sztucznej inteligencji. Celem tej inicjatywy jest zapewnienie ochrony praw człowieka i podstawowych wolności, a także zapobieganie dyskryminacji, zwiększenie przejrzystości i zapewnienie bezpieczeństwa użytkowników. AI Act traktuje technologię deepfake jako jeden z przykładów systemów sztucznej inteligencji wysokiego ryzyka. W związku z tym, stosowanie jej podlega szczególnym wymaganiom i ograniczeniom. Twórcy deepfake'ów mają obowiązek wyraźnie oznaczyć, że dana treść jest generowana przez system sztucznej inteligencji i nie jest prawdziwym zapisem rzeczywistych zdarzeń. AI Act wprowadza również wymóg, aby przed publikacją, tacy twórcy przeprowadzali ocenę ryzyka, która pozwoli na zidentyfikowanie potencjalnego szkodliwego wpływu materiały na osoby, grupy społeczne i/lub na demokratyczne procesy. W przypadku, gdy istnieje ryzyko szkodliwego wpływu deepfake'u, jego publikacja może zostać zakazana lub poddana ścisłym ograniczeniom.Deepfake a edukacja dzieci i młodzieży

Sztuczna inteligencja, a w szczególności generowanie deepfake'ów, budzi wiele kontrowersji i obaw. Niepokojące jest też szybkie tempo rozwoju tej technologii, co utrudnia dostosowanie się do zagrożeń, jakie może ona stwarzać - w ciągu kilku miesięcy aktualna wiedza i opracowane środki zaradcze mogą stać się nieaktualne w świetle nowych osiągnięć w tej dziedzinie.

Sztuczna inteligencja, a w szczególności generowanie deepfake'ów, budzi wiele kontrowersji i obaw. Niepokojące jest też szybkie tempo rozwoju tej technologii, co utrudnia dostosowanie się do zagrożeń, jakie może ona stwarzać - w ciągu kilku miesięcy aktualna wiedza i opracowane środki zaradcze mogą stać się nieaktualne w świetle nowych osiągnięć w tej dziedzinie.Z tego względu trzeba zdawać sobie sprawę z potencjalnych konsekwencji, jakie niesie technologia deepfake. Sztuczna inteligencja wykorzystywana w tego typu materiałach, podobnie jak każda inna technologia, może być użyta w zarówno dobrym, jak i złym celu. Z jednej strony, może pomóc w poprawie jakości produkcji filmowych i dźwiękowych, w tworzeniu bardziej realistycznych efektów specjalnych, przyśpieszyć i zmniejszyć koszty wielu procesów w branży kinematograficznej, a wraz z tym stworzyć nowe możliwości dla mniejszych wytwórni artystycznych oraz twórców amatorskich.

Z drugiej strony, sztuczna inteligencja może pomagać w manipulowaniu informacjami i tworzeniu fałszywych treści, które szerzą dezinformację, a także powodują szkody dla ludzi i społeczeństwa. Konieczne jest również zwrócenie uwagi na kwestie etyczne, takie jak prywatność i bezpieczeństwo danych oraz odpowiedzialne wykorzystanie sztucznej inteligencji.

Temat deepfake'ów musi więc stać się powszechnie znany. Oprócz osobistej świadomości problemu, warto rozmawiać o nim i przekazywać wiedzę dalej. Szczególnie ważne jest propagowanie wiedzy o tej technologii wśród dzieci i osób starszych, które mogą być szczególnie narażone na oszustwa. Wraz z dogłębną nauką krytycznego myślenia i rozwijania umiejętności weryfikacji informacji, są to kompetencje, które w przyszłości mogą okazać się nieocenione. Sztuczna inteligencja zaczyna wpływać na coraz więcej aspektów naszego życia, dlatego istotne jest również przybliżenie dzieciom informacji na temat tej technologii, korzyści, jakie niesie, ale również wyzwań, z jakimi będą się mierzyć nowe pokolenia. Tylko w ten sposób będą mogły stać się świadomymi i odpowiedzialnymi użytkownikami technologii.

dr Ewelina Bartuzi-Trokielewicz

NASK

Ekspert w dziedzinie biometrii i uczenia maszynowego. Od 2016 pracuje w NASK w Zakładzie Biometrii, doktor nauk technicznych, absolwentka Politechniki Warszawskiej i autorka wielu publikacji naukowych dotyczących wykorzystywania machine learning w różnych dziedzinach nauki. Specjalizuje się w zagadnieniach rozpoznawania tożsamości i identyfikacji osób, a także wykrywania fałszerstw. Ma szeroką wiedzę w zakresie teorii i praktyki dotyczącą działania sieci neuronowych, uczenia maszynowego, uczenia głębokiego, widzenia komputerowego. Brała udział w licznych projektach B+R, gdzie głównie zajmowała się rozwojem i analizą systemów biometrycznych, wykrywaniem ataków, metodami rozpoznawania wzorców i obrazów. Entuzjastka metod uczenia maszynowego, deep learningu oraz computer vision. Interesuje się psychologią, lubi podróżować, czytać książki i uprawiać rośliny.

Michał Ołowski

NASK

Członek Zakładu Biometrii w NASK. Prowadzi badania i prace w obszarze rozpoznawania tożsamości i sposobów na jej fałszowanie, z wykorzystaniem technik uczenia maszynowego, ze szczególnym uwzględnieniem technik deepfake. Autor i współautor materiałów popularnonaukowych i dydaktycznych w tematach związanych ze sztuczną inteligencją, wizją komputerową i biometrią. Jest absolwentem fizyki technicznej na Politechnice Warszawskiej.

Adrian Kordas

NASK

Pracownik Zakładu Biometrii NASK, student Polsko Japońskiej Akademii Technik Komputerowych i zaangażowany członek koła naukowego Data Science Club. Pasjonat informatyki i filmów science fiction. Z tej mieszanki powstało zamiłowanie do sztucznej inteligencji, a w szczególności w zakresie wizji maszynowej. Praca inżynierska jego autorstwa obejmująca zagadnienia rozpoznawania obrazów została wyróżniona i należy do najlepiej ocenianych prac dyplomowych Wydziału Informatyki PJATK. Współautor materiałów popularnonaukowych i dydaktycznych obejmujących tematykę szeroko pojętej AI. Miłośnik motoryzacji, wędkarstwa, sportów wodnych i zwierząt.